Avec le recul (c’est-à-dire après qu’un accident a eu lieu), il est souvent facile de revenir sur une situation et de la décrire comme un accident qui devait arriver. Trop souvent, nous en restons là, espérant peut-être que quelqu’un d’autre cherchera à comprendre comment on aurait pu le prévoir. Quelqu’un l’a fait.

Charles Perrow a passé en revue toute une série de technologies, notamment la pétrochimie et les centrales nucléaires, les barrages, les mines, l’armement et la recherche spatiale, l’aviation et les voies aériennes, la recherche sur l’ADN et le transport de marchandises, et a écrit une analyse pénétrante et convaincante sur les types de systèmes dans lesquels les accidents sont inévitables, ou "normaux" dans sa terminologie (1). Les centrales nucléaires sont d’excellents exemples de tels systèmes.

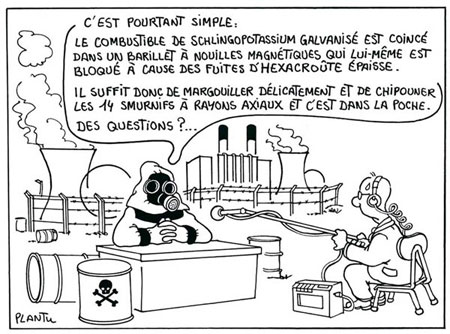

La complexité implique l’accident

Selon Perrow, les accidents normaux se produisent dans les systèmes qui partagent un certain nombre de caractéristiques clés. Tout d’abord, le système a de nombreux composants (pièces, procédures et opérateurs), disposés de manière complexe. (Autrement dit, ce n’est pas un long processus linéaire où tout ce qui arrive, c’est que A mène à B qui mène à C, etc., et qui peut être arrêté facilement à tout moment.)

Dans un tel système (avec de nombreux composants disposés de façon complexe), il est évident que de nombreux petits dysfonctionnements - des choses comme des interrupteurs défectueux, des ampoules grillées, des erreurs mineures commises par des opérateurs - se produiront. Ces dysfonctionnements ne devraient pas en principe être catastrophiques, car de nombreux systèmes d’intervention de back-up et d’urgence - également complexes - sont en place.

Les dysfonctionnements mineurs interagissent

La deuxième caractéristique d’un système qui, selon l’analyse de Perrow, rencontre des accidents normaux, c’est que deux ou plusieurs dysfonctionnements (de pièces, de procédures ou de jugement de l’opérateur) - dysfonctionnements qui pourraient être sans incidence en eux-mêmes - peuvent interagir de manière inattendue. Par exemple, une partie P (une ampoule sur une jauge) peut tomber en panne au moment où la partie Q (partie d’un système de secours) est hors-ligne pour des raisons de maintenance. La panne de la pièce P pourrait laisser les opérateurs ignorer qu’un problème était en train de se développer ; l’état inactif de la partie Q peut désactiver le système de secours qui aurait (probablement) soit alerté les opérateurs du problème, soit arrêté les composants désormais dangereux.

Mais le problème ne fait que commencer. D’une part, les opérateurs peuvent ne pas savoir que quelque chose d’inhabituel se passe. Il se passe tant de choses, que dans un système avec littéralement des milliards de composants, il se peut qu’ils ne sachent pas que la partie Q n’est pas en ligne. Ils n’ont aucun moyen de savoir que l’ampoule dans une jauge particulière devrait clignoter sur "danger". Le système complexe, avec toutes ses jauges, tous ses systèmes de secours, et tous ses processus interdépendants (par exemple, certaines pompes s’allument automatiquement lorsque la température dans une zone donnée atteint un seuil pré-établi, ou que les jauges indiquent que la température a franchi ce seuil), continue à fonctionner et réagir. Jusqu’à ce que d’autres choses aillent "mal", les opérateurs ne seront pas conscients qu’il existe un problème. Au moment où ils s’apercevront qu’il y a un problème, ils seront incapables d’agir de manière appropriée, car ils n’ont aucun moyen de savoir ce qui s’est passé d’autre.

En cas de problème, les procédures sont impuissantes

Dans le cas de l’accident de la centrale nucléaire de Three Mile Island (1979), il a fallu passer au crible pendant plusieurs mois les données informatiques, effectuer de nombreuses interviews et de nombreuses analyses techniques avant qu’un scénario raisonnable de "ce qui s’est passé" puisse être élaboré. Cette circonstance conduit à une contradiction inhérente aux systèmes à haut risque : les procédures mêmes qui sont nécessaires pendant les opérations normales sont désespérément inadéquates en cas d’urgence.

En fonctionnement normal, une équipe de contrôle centralisée doit savoir exactement ce que fait chaque opérateur, de sorte qu’une personne ne fasse pas quelque chose qui pourrait interagir avec un autre composant mettant ainsi en danger l’ensemble du système. Par conséquent, les procédures d’opération doivent être fixes et exactes. Cependant, les accidents ont tendance à se produire lorsque des événements pour lesquels il n’existe pas de procédures claires se produisent. L’absence de procédures, combinée à l’ignorance des opérateurs concernant l’état exact des choses, signifie que les opérateurs doivent prendre des mesures arbitraires basées sur leur meilleure estimation de ce qui se passe.

Sans toutefois suggérer que les systèmes de secours et les dispositifs de sécurité redondants devraient être éliminés, Perrow constate que ces mesures ajoutent à la complexité d’un système et réduisent la probabilité de la compréhension d’un problème en temps utile.

Par exemple, supposons que, pour assurer l’exactitude d’une indication donnée sur pupitre de commande concernant une mesure très importante, il y ait non pas une mais deux jauges mesurant la quantité d’eau dans un réservoir. Supposons maintenant que l’une montre que le réservoir est vide et l’autre qu’il est plein. Une jauge est-elle cassée ? Si oui, laquelle ? Le réservoir est-il vide ou plein ? Peut-être qu’il est à moitié plein, et que les deux jauges sont défectueuses ou déconnectées.

Supposons qu’un réservoir partiellement rempli puisse expliquer des fuites observées, et qu’un réservoir vide puisse expliquer la surchauffe. Que faire si les autres jauges ne suggèrent ni fuite, ni surchauffe ? Les deux jauges sont-elles exactes, ou seulement l’une des deux ou les deux sont-elles défectueuses, et si oui, laquelle ou lesquelles ? Et ainsi de suite. Même dans ce cas hypothétique grossièrement simplifié, les possibilités se multiplient rapidement dès lors qu’un doute possible s’insinue vis-à-vis de chaque élément d’information.

Le vrai critère : la gravité du danger

Dans certaines technologies, les accidents normaux sont relativement fréquents mais limités dans leur potentiel catastrophique. Les éoliennes peuvent être dangereuses et ont causé des blessures horribles à des techniciens de maintenance, mais elles ne vont pas se détacher et partir en vrille en décapitant des milliers de personnes. Dans les technologies nucléaires, le potentiel catastrophique est immense, comme nous le voyons à nouveau à Fukushima. Les accidents nucléaires, vus à travers une analyse historique ou systémique, sont une certitude. C’est de l’arrogance de penser autrement.

Jane Anne Morris

Cet article est un extrait modifié du livre de Jane Anne Morris, Not In My Back Yard : The Handbook (Editions Silvercat, 1994), p. 245.

Intervenante en entreprise et résidente à Madison, l’anthropologue Jane Anne Morris est aussi

l’auteure de Gaveling Down the Rabble : How "Free Trade" is stealing our democracy (Comment

le "libre-échange" nous vole la démocratie)

(Apex Press, 2008). Son site web est : https://democracythemepark.org

Source : revue Synthesis/Regeneration n°57, www.greens.org. Traduit de l’anglais au français par Annie Adam Parry pour le Réseau "Sortir du nucléaire". Les intertitres ont été ajoutés par la rédaction.

Notes :

1 : Le livre de Charles Perrow publié en 1984, Normal Accidents : Living with High-Risk Technologies (Les accidents normaux : vivre avec les technologies à haut risque, Basic Books, New York, 1984), offre un cadre pour évaluer et réduire les risques d’accidents dans les différentes technologies industrielles.

Tous les 3 mois, retrouvez 36 pages (en couleur) de brèves, interviews, articles, BD, alternatives concrètes, actions originales, luttes antinucléaires à l’étranger, décryptages, etc.